Indice

- Privacy e protezione dei dati

- IA etica e mitigazione dei bias

- Trasparenza e interpretabilità

- Responsabilità e oneri

- I quadri normativi

- Passi pratici per la compliance

- Conclusioni

Ogni innovazione tecnologica, soprattutto quelle più dirompenti, porta con sé grandi benefici che, tuttavia, lasciano dietro di sé delle ombre. La velocità di diffusione dell'IA, in particolare degli LLm, ha sollevato sempre più preoccupazioni da parte delle autorità. Monopoli, gestione dei dati, privacy, pregiudizi e impatto sociale sono solo alcuni dei punti sotto la lente d'ingrandimento delle istituzioni; in questo articolo, facciamo luce su ciò che bisogna sapere per districarsi in questo labirinto, aprendo la strada a un'innovazione trasparente e responsabile.

Privacy e protezione dei dati

La prima preoccupazione riguarda la privacy dei dati. I sistemi di intelligenza artificiale spesso elaborano grandi quantità di dati, comprese informazioni personali sensibili; l'attenzione degli utenti alla condivisione dei propri dati sta crescendo a tal punto che alcune aziende, come Apple, stanno utilizzando la privacy per differenziare i propri prodotti dalla concorrenza.

Regolamenti come il Regolamento generale sulla protezione dei dati (GDPR) nell'Unione Europea impongono requisiti severi sulla raccolta, l'archiviazione e l'elaborazione dei dati; negli ultimi mesi, grazie a questo regolamento, molti utenti europei di Meta hanno potuto negare alla piattaforma la possibilità di utilizzare i loro dati per l'addestramento del nuovo modello AI di Meta.

Le aziende devono assicurarsi che i loro sistemi di IA siano conformi a queste normative; la non conformità alle norme sulla privacy dei dati può comportare multe significative e danni alla reputazione. Diventa necessario implementare solide politiche di governance dei dati e utilizzare tecniche di anonimizzazione dei dati per proteggere le informazioni personali.

IA etica e mitigazione dei bias

I sistemi di IA possono involontariamente perpetuare i pregiudizi presenti nei dati di addestramento, portando a risultati ingiusti o discriminatori. I quadri normativi sottolineano sempre più la necessità di pratiche etiche di IA per garantire l'equità e la non discriminazione. Le aziende devono identificare e mitigare in modo proattivo i pregiudizi presenti nei loro sistemi di IA, utilizzando insiemi di dati diversi e conducendo verifiche regolari. Solo con una tecnologia e un'infrastruttura di dati solide, si può sbloccare la vera potenza dell'IA.

Trasparenza e interpretabilità

La trasparenza nel processo decisionale dell'IA è fondamentale, soprattutto in settori ad alto rischio come la finanza, la sanità o le forze dell'ordine. Le normative spingono per una maggiore interpretabilità, richiedendo alle aziende di fornire spiegazioni chiare e comprensibili dei processi e delle decisioni in materia di IA. Nell'ultimo periodo gran parte della ricerca nel mondo dell'IA si è concentrata su questo aspetto, riuscendo a ottenere buoni risultati utilizzando modelli sempre più trasparenti e interpretabili.

Responsabilità e oneri

Man mano che i sistemi di IA si integrano sempre più nelle operazioni aziendali, le questioni relative alla responsabilità diventano sempre più rilevanti. Gli enti normativi stanno lavorando per stabilire linee guida chiare sulla responsabilità dell'IA, sottolineando la necessità di una supervisione umana. Le aziende devono implementare quadri di governance che definiscano le responsabilità e garantiscano la conformità a questi standard. Strutture chiare di responsabilità aiutano a prevenire le controversie legali e a migliorare l'integrità operativa. L'implementazione di meccanismi di supervisione garantisce un impiego responsabile dell'IA e rafforza la fiducia degli stakeholder.

I quadri normativi

Gli Stati stanno affrontando la regolamentazione in modo piuttosto diverso l'uno dall'altro, non c'è ancora una chiara convergenza, ma la speranza è che si possa trovare una chiave comune per prevenire l'uso improprio di questa tecnologia e allo stesso tempo incentivarne l'utilizzo. La comprensione dei principali quadri normativi, però, rimane essenziale per le aziende per garantire la conformità e l'allineamento strategico.

Legge sull'AI dell'Unione Europea

L'AI Act dell'Unione Europea classifica i sistemi di intelligenza artificiale in diversi livelli di rischio, con i sistemi ad alto rischio soggetti a soddisfare requisiti rigorosi. Questi includono test, documentazione e supervisione umana. Le aziende che operano nell'UE devono allineare le loro pratiche di IA a queste normative per evitare sanzioni e garantire l'accesso al mercato.

L'approccio degli Stati Uniti

Negli Stati Uniti la regolamentazione dell'IA è meno centralizzata, con varie iniziative a livello federale e statale. La Federal Trade Commission (FTC) ha emanato linee guida che sottolineano l'equità, la trasparenza e la responsabilità. Le aziende devono tenersi informate su queste normative, ancora in evoluzione per garantire la conformità. La navigazione nel frammentato panorama normativo degli Stati Uniti richiede un monitoraggio e un adattamento continui. Collaborare con esperti legali e organismi di settore può aiutare le aziende a stare al passo con i cambiamenti normativi.

Standard globali

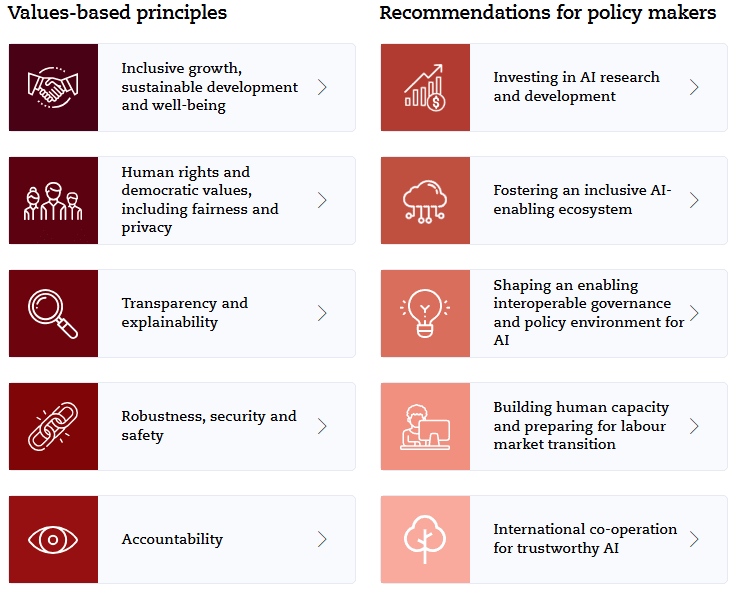

Organizzazioni internazionali come l'Organizzazione per la Cooperazione e lo Sviluppo Economico (OCSE) hanno stabilito principi di IA che enfatizzano la crescita inclusiva, i valori incentrati sull'uomo e la responsabilità. L'allineamento a questi standard globali può aiutare le aziende a garantire una più ampia conformità e pratiche etiche.

Passi pratici per la compliance

La gestione delle normative sull'IA richiede, dunque, un approccio strategico e proattivo. Ecco i passi pratici che le aziende devono compiere per garantire la conformità e promuovere un uso responsabile dell'IA.

- Eseguire valutazioni d'impatto complete: Prima di implementare sistemi di IA, è necessario condurre valutazioni d'impatto approfondite per identificare i rischi potenziali e i requisiti normativi. La documentazione di queste valutazioni può dimostrare la conformità e guidare lo sviluppo etico dell'IA.

- Implementare quadri di governance solidi: Stabilire solidi quadri di governance che definiscano chiaramente ruoli e responsabilità. Implementare meccanismi di supervisione e condurre audit regolari per garantire la conformità agli standard normativi.

- Promuovere una cultura dell'etica e della trasparenza: Formare i dipendenti sulle pratiche etiche dell'IA e incoraggiare un dialogo aperto sui rischi e le sfide potenziali. Mantenere una comunicazione chiara con gli stakeholder sui processi e le decisioni in materia di IA.

- Rimanere informati e adattarsi: Il panorama normativo dell'IA è in continua evoluzione. Rimanere informati su nuove linee guida e standard con gli enti del settore, partecipando a forum sull'IA e consultando esperti legali per mitigare i rischi.

- Sfruttare la tecnologia per la compliance: Utilizzare strumenti basati sull'intelligenza artificiale per l'anonimizzazione dei dati, l'interpretabilità e il rilevamento dei bias per migliorare gli sforzi di conformità. Investire in queste tecnologie può semplificare l'aderenza alle normative e creare fiducia nei sistemi di IA.

Conclusioni

Il panorama normativo dell'IA è in rapida evoluzione e presenta sia sfide che opportunità per le aziende. Navigare nelle normative sull'IA può essere complesso, Neodata offre una guida esperta e soluzioni innovative per aiutare la vostra azienda a rimanere conforme e a sfruttare appieno il potenziale dell'IA. contattaci a info@neodatagroup.ai per scoprire come possiamo il vostro viaggio nel mondo dell'IA e garantire che la vostra azienda usi le corrette strategie in un panorama normativo in continua evoluzione.

AI Evangelist e Marketing specialist per Neodata

- Diego Arnonehttps://neodatagroup.ai/it/author/diego/

- Diego Arnonehttps://neodatagroup.ai/it/author/diego/

- Diego Arnonehttps://neodatagroup.ai/it/author/diego/

- Diego Arnonehttps://neodatagroup.ai/it/author/diego/